Produkt wytworzony przez sztuczną inteligencję co prawda wygląda jak tekst, a choćby coraz doskonałej go symuluje, ale nie jest tekstem we adekwatnym rozumieniu tego słowa.

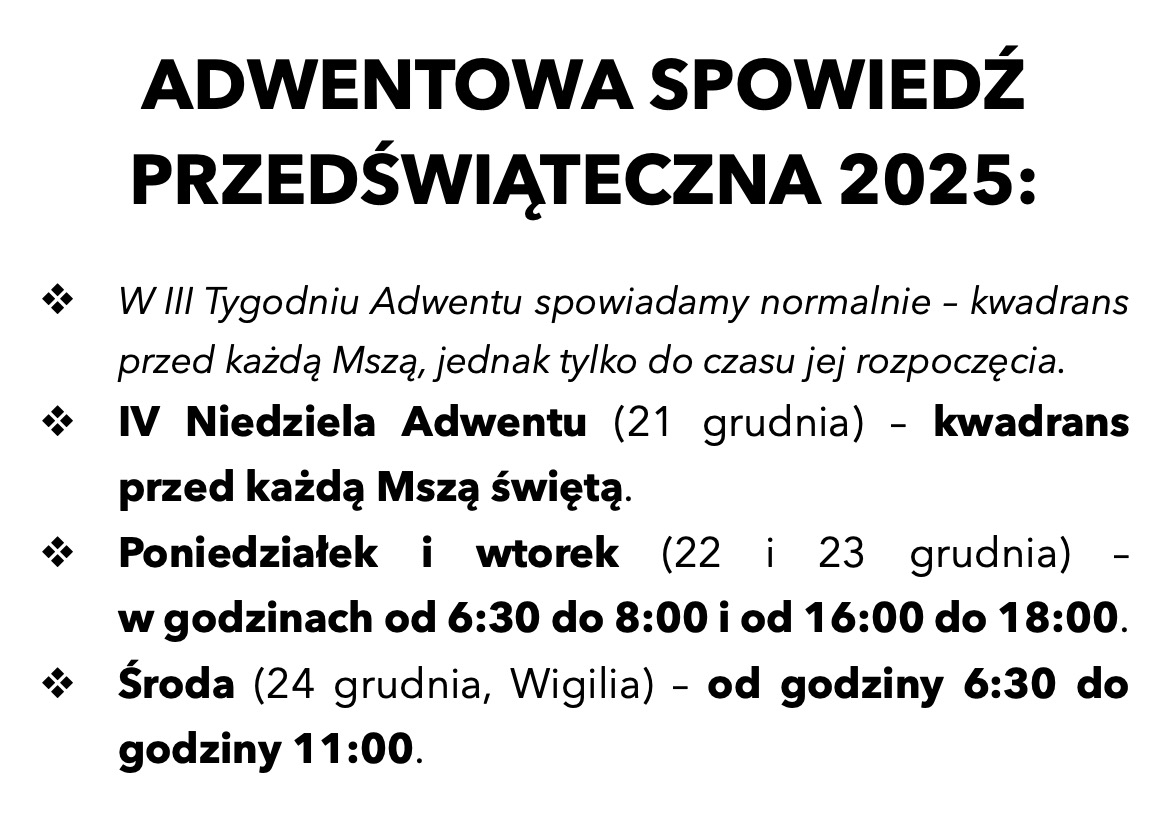

Czy ChatGPT może funkcjonować jako pomocnik kaznodziei? Temat ten, wraz z rozwojem sztucznej inteligencji, staje się w Kościele coraz bardziej aktualny. Na łamach portalu Więź.pl w tekście „Kaznodzieje-złodzieje w czasach sztucznej inteligencji” podjął go ks. Andrzej Draguła. Ponieważ kwestia ta sama w sobie jest złożona, chciałbym zatrzymać się przy wątku, który w artykule Andrzeja Draguły się nie pojawił, a, jak sądzę, jest godzien uwagi. Jest nim status tekstów wygenerowanych przez AI.

WIĘŹ – łączymy w czasach chaosu

Więź.pl to pogłębiona publicystyka, oryginalne śledztwa dziennikarskie i nieoczywiste podcasty – wszystko za darmo! Tu znajdziesz lifestyle myślący, przestrzeń dialogu, personalistyczną wrażliwość i opcję na rzecz skrzywdzonych.

Czytam – WIĘŹ jestem. Czytam – więc wspieram

Według mnie pytanie o tenże status, a konkretnie o to, czy teksty te zasługują na miano mowy w ściśle ludzkim sensie mówienia, jest w kontekście głoszenia Słowa pytaniem ważnym. Co więcej, z licznych rozmów wywnioskowałem, iż moje stanowisko w tej kwestii jest często traktowane jako „radykalne”. Tym bardziej więc warto je poddać szerszej dyskusji.

Rozważanie pytania o status tekstu wygenerowanego przez AI rozwinę wokół tej samej sytuacji, która stała się punktem wyjścia do artykułu Andrzeja Draguły. Ten punkt wyjścia wydaje mi się stosowny, gdyż, jak wieść gminna niesie, wielu księży, przygotowując homilie, używa ChatGPT. Co prawda nigdy nie zdarzyło mi się rozmawiać z kaznodzieją, który by opowiadał, iż sam korzysta z takiego „pomocnika”, ale słyszałem ogólne stwierdzenia o istnieniu tej praktyki.

„Ułóż kazanie o obłudnikach”

Rozważanie to zacząć należy od fundamentalnego pytania: Czy można wykorzystywać ChatGPT jako pomoc w przygotowywaniu homilii, kazania, nauki rekolekcyjnej? Moim zdaniem – nie.

Odpowiedź ta dotyczy takiego wykorzystania sztucznej inteligencji, w którym, po wpisaniu odpowiedniego polecenia, algorytm produkuje „tekst”, który staje się następnie materiałem do dalszego wykorzystania: wygłoszenia albo przetworzenia. Przykładem mogłoby być polecenie: „Odwołując się do św. Augustyna, ułóż tekst kazania o obłudnikach”. Na jego podstawie użytkownik otrzyma wytworzony przez ChatGPT „tekst”. choćby o ile pojawią się w nim rzekome cytaty z Augustyna, nie ma żadnej pewności, iż są one prawdziwe.

Moja kategoryczna odpowiedź nie dotyczy natomiast wykorzystania sztucznej inteligencji jako zaawansowanej wyszukiwarki tekstów. Za przykład niech posłuży sytuacja, w której ktoś zadaje ChatGPT w odpowiednio ustawionym trybie zadanie: „Wyszukaj mi wypowiedzi św. Augustyna o obłudnikach”. Jako wykonane zadanie otrzymuje on cytaty z Augustyna. Z pewną dozą prawdopodobieństwa może uznać, iż są one prawdziwe. Co prawda ChatGPT jako wyszukiwarka ma kiepską reputację, a do tego też czasem konfabuluje, jednak według mnie nie jest to problem, który wykluczałby stosowanie go jako wyszukiwarki pomocnej w przygotowaniu homilii przy odpowiedniej weryfikacji wyniku wyszukiwania w tekstach źródłowych.

„Tekst” nierówny tekstowi

Podstawową różnicę między tymi dwiema sytuacjami uwidoczniłem używając cudzysłowu: w pierwszej sytuacji ChatGPT dostarcza „tekst”, który jest produktem tegoż algorytmu – produktem, a nie tylko kompilacją źródłowych tekstów ludzkich. Sztuczna inteligencja wytwarza bowiem własną strukturę tekstu. choćby o ile są w tym „tekście” odwołania do Augustyna, te odwołania i rzekome słowa Augustyna są produktem algorytmu.

Maszynowe „autorstwo” sprawia, iż wygenerowany przez ChatGPT „tekst” niesie w sobie pierwotną pustkę i nijakość. Nie ma bowiem źródła sensu – człowieka jako autora wypowiedzi

Ks. Jan Słomka

W drugiej sytuacji natomiast dostarczone teksty napisane są przez człowieka, w tym przykładzie – św. Augustyna. Właśnie ta różnica jest podstawą mojej negatywnej odpowiedzi. Produkt wytworzony przez ChatGPT co prawda wygląda jak tekst, a choćby coraz doskonałej tekst symuluje – tak doskonale, iż czasem trudno odróżnić go od wytworu człowieka – ale nie jest tekstem we adekwatnym rozumieniu tego słowa.

Skąd to przekonanie? Tekst oznacza zapisaną wypowiedź człowieka. Przed pojawieniem się ChatGPT przeświadczenie, iż tekst jest dziełem ludzkim, było tak oczywiste, iż nikt się nad nim nie zastanawiał. Co prawda w XX wieku pojawiły się teorie językoznawcze traktujące tekst w oderwaniu od autora, ale powstawały one bez kontekstu sztucznej inteligencji. Oderwanie to rozważane było ostatecznie przy założeniu, iż u początku tekstu stał autor – człowiek. Wprowadzenie sztucznej inteligencji zakwestionowało tę oczywistość. Należy w związku z tym przemyśleć naturę tekstu, aby ustalić, czy produkt ChatGPT zasługuje na tę nazwę. W moim odczuciu – nie.

Plagiaty klasyczne i nowe

Pozwolę sobie na małą dygresję, pokazującą jeden z wielu kłopotów wywołanych przez wprowadzenie do obiegu ChatGPT i jemu podobnych algorytmów AI. Otóż problem plagiatów jest tak stary jak pismo. Również od początku istnienia czasopism i monografii naukowych wykrywanie i wykluczanie plagiatów jest stałym elementem pracy wydawnictw naukowych. Przeniesienie większości publikacji naukowych do formy cyfrowej i rozwój baz danych oraz systemu sprawiły, iż wykrywanie i udowadnianie plagiatów stało się relatywnie proste. Programy antyplagiatowe działają coraz lepiej.

Ostatnio pojawił się jednak nowy problem: wklejanie do tekstów naukowych fragmentów „tekstów” wygenerowanych przez AI i niesygnalizowanie w przypisach czy w inny sposób tej praktyki. Na razie nie istnieją żadne programy potrafiące odróżnić produkt sztucznej inteligencji od tekstu napisanego przez człowieka. Wobec tego, choćby o ile recenzent nabiera podejrzeń co do nieuprawnionego i niezgłoszonego użycia „tekstu” wygenerowanego przez AI, udowodnienie autorowi, iż dokonał takiego nadużycia, jest niezwykle trudne.

Choć mogę się mylić, sądzę, iż algorytmy nigdy sobie z tym nie poradzą: z samej natury algorytmu wynika niemożność odróżnienia „tekstu” wygenerowanego przez inny algorytm od tekstu napisanego przez człowieka. Tak więc kłopot z oszustwami naukowymi polegającymi na wklejaniu do prac naukowych „tekstu” wygenerowanego przez sztuczną inteligencję długo pozostanie problemem o wiele poważniejszym niż walka z plagiatami.

Inspiracja z chata?

Co jednak jeżeli kaznodzieja, przygotowując wypowiedź, uruchamia ChatGPT i przegląda wyprodukowane przez ten algorytm „teksty” wyłącznie szukając inspiracji i na jej podstawie pisze własny, „ludzki” tekst, faktycznie jego autorstwa? Każda fraza podsunięta przez sztuczną inteligencję, choćby o ile pozostała niezmodyfikowana, jest przyjęta, zaakceptowana przez kaznodzieję. Jest więc ona niejako dotknięta przez jego ludzkie serce, jego człowieczeństwo.

- Ks. Andrzej Draguła

Ekstaza miłosiernego Samarytanina

Według mnie jednak taka praktyka jest co najmniej zbędnym wysiłkiem, czyli poświęcaniem uwagi ludzkiej produktowi, który na nią – jako symulacja tekstu – nie zasługuje. Próby doszukiwania się w „tekście” wygenerowanym przez AI sensu są daremnym zużywaniem cennego ludzkiego zasobu: tego rodzaju uwagi, jaką poświęcamy innemu człowiekowi lub jego dziełu.

Pustka i nijakość „tekstu”

Przypuszczam jednak, iż szkodliwość korzystania z AI podczas przygotowywania kazania nie ogranicza się do straty czasu i daremnego wysiłku. Każdy bowiem tekst, który jest czymś więcej niż słowo lub fraza słownikowa, tekst, który ma swoją strukturę, zawiera w sobie ślad autorstwa. Maszynowe „autorstwo” sprawia, iż wygenerowany przez ChatGPT „tekst” niesie w sobie pierwotną pustkę i nijakość. Nie ma bowiem źródła sensu – człowieka jako autora wypowiedzi. Czym dłuższy „tekst” bierze się na warsztat, tym większe jest ciążenie owej pierwotnej pustki i nijakości.

W powyższych stwierdzeniach zawarta jest teza, iż sens tekstów ludzkich zasysanych przez algorytmy AI nie jest w stanie ostać się w procedurze maszynowej kompilacji produkującej „tekst” wychodzący z ChatGPT. Teza ta w swojej wersji radykalnej okazała się nieprawdziwa. Już bowiem wiadomo, iż „teksty” generowane przez AI przenoszą z zassanych źródeł na przykład uprzedzenia rasowe. Może to być punkt zaczepienia dla dalszych dyskusji o sensie wykorzystywania AI w przygotowywaniu tekstów używanych podczas głoszenia Słowa Bożego: na przykład do traktowania sztucznej inteligencji jako biblijnej oślicy Balaama.

Ja pozostaję jednak przy przekonaniu, iż opisana powyżej skaza jest tak poważna, iż zrywa więź międzyludzką, która jest istotą mowy. Porozrywane strzępy sensu, jakie przedostają się przez maszynkę algorytmów, nie usprawiedliwiają wysiłku wkładanego w analizę produktu ChatGPT. Pojawia się natomiast ryzyko, iż frazy zaczerpnięte przez kaznodzieję z takiego „tekstu” niejako „zarażą” swoją pustką i nijakością jego wypowiedź. Jest też dla mnie oczywiste, iż w trakcie generowania „tekstu” AI nie wytwarza żadnego sensu.

Międzyludzki charakter języka i pisma

Wspomniana wyżej skaza „tekstu” wygenerowanego w procesie kompilacji maszynowej polega na zerwaniu więzi międzyludzkiej, czyli na zniszczeniu miejsca, w którym żyje słowo, tekst. Słowo mówione i pisane powstało bowiem jako adekwatne człowiekowi medium relacji międzyludzkiej. Żyje ono w tej relacji jako forma porozumienia międzyludzkiego.

Skaza „tekstu” wygenerowanego w procesie kompilacji maszynowej polega na zerwaniu więzi międzyludzkiej, czyli na zniszczeniu miejsca, w którym żyje słowo, tekst

Ks. Jan Słomka

Z tego właśnie założenia wyprowadziłem stwierdzenie, iż tylko tekst napisany lub podyktowany przez człowieka godzien jest takiej uwagi, jaką od powstania pisma my, ludzie, poświęcamy pismu – dziełu człowieka stworzonemu dla innego człowieka. Ten pierwotnie międzyludzki charakter mowy i słów pokazał Augustyn, wspominając, jak w dzieciństwie uczył się mówić:

Zachowywałem w pamięci dźwięk, jakim oni daną rzecz nazywali, i gdy widziałem, iż pod wpływem takiego dźwięku poruszają się w pewnym kierunku, pojmowałem, iż nazywają daną rzecz tym właśnie dźwiękiem, który wypowiadają wtedy, kiedy chcą na nią wskazać. Tę ich intencję poznawałem z ruchów ciała, z czegoś, co jest jakby naturalną mową wszystkich ludzi, wszystkich ludów, polegającą na wyrazie twarzy, poruszeniach oczu, na różnych gestach, jak też na samym brzmieniu głosu, które ujawnia nastawienie wewnętrzne człowieka w prośbach, stwierdzeniach, odmowach i poleceniach. Stopniowo rozpoznawałem, jakie rzeczy oznaczane są słowami, które się często pojawiały w określonych miejscach różnych zdań, a opanowawszy wymowę tych słów, wyrażałem za ich pomocą własne życzenia. Odtąd mogłem wymieniać znaki życzeń z ludźmi, pośród których żyłem (Wyznania 1,8 przeł. Z. Kubiak).

Chociaż pismo nie przenosi tego wszystkiego, co Augustyn opisał jako „naturalną mowę wszystkich ludów”, zachowuje ono jednak pierwotnie międzyludzki charakter mowy, mowę jako porozumienie, jako „wymianę znaków życzeń z ludźmi”. Istotą tego porozumienia niesionego przez słowa jest sens, który rodzi się w sercu człowieka, a zamieszkuje w relacji międzyludzkiej. o ile więc czasem czytamy zdania na pierwszy rzut oka bezsensowne, poświęcając im uwagę i zastanawiając się nad ich ewentualną sensownością, to tylko na podstawie założenia, iż są to zdania ludzkie. Również gdy męczymy się, poświęcając dużo czasu, uwagi i wysiłku trudnemu do zrozumienia tekstowi, robimy to na podstawie zaufania. Na przykład teksty klasyków filozofii zwykle powoli i z oporem ujawniają swoje znaczenie. Wysiłek podejmujemy na podstawie zaufania do tych, którzy czytali i zrozumieli je przed nami.

Naruszenie podstaw zaufania

W przypadku kaznodziei czy rekolekcjonisty podane wyżej rozróżnienie między tekstem ludzkim, a „tekstem” wygenerowanym przez AI nabiera wyjątkowego znaczenia. Homilia, kazanie, nauka rekolekcyjna są bowiem uczestniczeniem w Słowie Bożym. Są wygłaszane i słuchane w przestrzeni wiary, w której Słowo Boże jest głoszone i dociera do serc słuchaczy. Ta przestrzeń zbudowana jest z elementarnego zaufania słuchaczy do głosiciela.

W samych fundamentach tego zaufania znajduje się dotychczas oczywiste założenie, iż głosiciel mówi słowa – piękne lub nieporadne – które wychodzą z jego serca; słowa ludzkie, choćby o ile zapożyczone, to zapożyczone od człowieka. Wpuszczanie w tę przestrzeń fragmentów „tekstu” wyprodukowanego przez ChatGPT jest bardzo głębokim naruszeniem podstaw zaufania słuchaczy. Naruszenie to jest według mnie bardziej naganne niż wklejanie „tekstu” wygenerowanego przez AI w pracy naukowej.

Fraza wyprodukowana przez sztuczną inteligencję wpleciona w homilię, kazanie, naukę rekolekcyjną, w swej pustce i nijakości nie jest choćby frazą głupią. Jest więc gorsza od nieżywej muchy, o której pisał Kohelet: „Nieżywa mucha zepsuje naczynie wonnego olejku. Bardziej niż mądrość, niż sława zaważy trochę głupoty” (Koh 10,1).

3 tygodni temu

3 tygodni temu